Le travail d'un data scientist expliqué en 6 étapes.

Comment se passe un projet de data science ? Qu’est-ce que cela apporte vraiment aux entreprises ? Décryptage et explication du métier de data scientist.

Le travail du data scientist est de développer des algorithmes autonomes dans la prise de décisions, d’où le nom d'intelligence artificielle. Les algorithmes de Machine et Deep learning - contrairement aux algorithmes classiques - sont capables lorsqu’on leur donne des données inconnues de décider seuls quoi faire.

Par exemple, un algorithme de deep learning entraîné à la détection sur image est capable de reconnaître un chien sur une photo de manière totalement autonome.

Ces algorithmes, faits sur-mesure pour les besoins d’un projet, répondent à une multitude de problématiques métiers jusque-là sans réponses. Par exemple : l’automatisation de nombreux processus, une aide à la décision optimisée, des prédictions fiables dans le temps ou une compréhension personnalisée de ses clients.

La principale condition au bon déroulement d’un projet de data scientist est d’avoir des données exploitables et en quantité suffisante. Ces données sont utilisées pour nourrir l’algorithme et ainsi l'entraîner pour être le plus performant possible.

1. Récupérer les données

La genèse de tout projet dans l’IA est d’avoir des données exploitables. La première étape consiste donc à récupérer ces fameuses données là où elles se trouvent, c'est-à-dire… potentiellement partout !

En effet, toute donnée stockée quelque part peut potentiellement être pertinente pour le problème à résoudre. Toute donnée qui est en lien avec le sujet et la problématique du projet peut être potentiellement intéressante et utile. Des bases de données, du contenu internet, des enregistrements vocaux, des tableurs, des données brutes tels que des mails etc. La liste n’est jamais exhaustive !

Les données proviennent souvent de plusieurs sources différentes. Il est donc nécessaire de les rassembler toutes au même endroit. Suivant la quantité et la complexité des données, un architecte travaillera pour mettre en place une infrastructure capable de centraliser les données et de les mettre à disposition du data scientist.

Une fois que les sources de données sont clairement identifiées et que les données sont accessibles, le data scientist va passer à l’étape suivante, à savoir le nettoyage de ces données.

2. Nettoyage des données

Les données sont maintenant recueillies, l’objectif est d’en faire un jeu de données exploitable. Ce jeu de données exploitable servira à nourrir notre algorithme, à l'entraîner pour qu’il optimise ses performances et donne les meilleurs résultats possibles. Voilà toute l’importance du nettoyage de données. En s’assurant que les données sont de qualité et rigoureusement nettoyées, le data scientist garantit que l’algorithme va s'entraîner sur des données représentatives de ce qu’il pourra trouver en production.

Le nettoyage des données consiste alors à corriger toutes les erreurs lors de la saisie. Cela peut être des valeurs aberrantes (par exemple une taille humaine de 12 mètres) ou encore des données manquantes (un titre de mail non rempli par exemple).

L’objectif est de ne pas avoir d’erreur et de ne pas avoir de données erronées qui fausserait les résultats obtenus lorsque l’on va injecter le jeu de données dans l’algorithme.

3. Analyse et exploration des données

Le jeu de données est maintenant clair et exploitable, le data scientist va alors explorer les données pour leur donner du sens.

Cette partie relativement chronophage est essentielle pour bien comprendre le sens des données par rapport à la problématique à résoudre. Trouver des indicateurs pertinents et comprendre comment les données peuvent être utilisées est un des éléments clés lors d’un projet d’IA. L’idée est d’optimiser son jeu de données pour le rendre plus représentatif du phénomène qu’on cherche à comprendre. C’est le feature engineering.

Un(e) data scientist peut par exemple créer de nouvelles variables qui lui semblent pertinentes à partir des variables initiales du jeu de données.

Le travail d’analyse de données inhérent à chaque projet de machine learning ajoute par ailleurs une véritable plus-value au client en amont de l’utilisation d’un algorithme d’intelligence artificielle.

En effet les résultats de cette analyse, le sens des données et les conclusions de l'étude sont présentés aux métiers lors de la présentation des résultats.

4. Modélisation

Une fois le nettoyage et l’analyse faites, le jeu de données est prêt. La partie modélisation peut commencer.

On va chercher à expliquer par un modèle mathématique les données du jeu de dataset.

Les algorithmes de machine et deep learning sont des fonctions mathématiques qui à partir de données entrantes fournissent un résultat sortant. L’objectif de la modélisation est d'entraîner le modèle pour qu’il puisse trouver seul le résultat correctement et conformes aux attentes.

L’idée est d'entraîner le modèle avec le jeu de données test dont on connaît le résultat. Ainsi, lorsque l’algorithme est confronté à de nouvelles données, il est suffisamment entraîné et est capable de prendre des décisions de manière autonome.

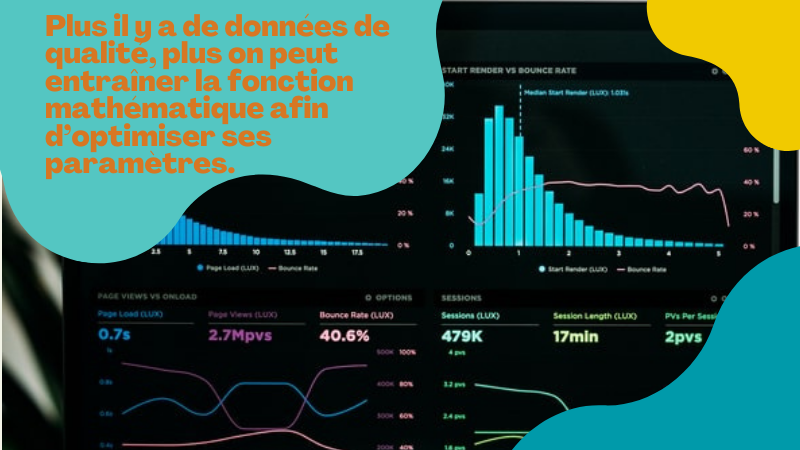

Voilà toute l’utilité d’un jeu de données de qualité. Plus il y a de données de qualité, plus on peut entraîner la fonction mathématique afin d’optimiser ses paramètres.

Pour garantir que l’algorithme est performant, le data scientist utilise des outils de scoring et des indicateurs tels que le biais et la variance. Ainsi, il est capable de déterminer qu’un algorithme a bien compris le phénomène sous-jacent au jeu de données, et peut être mis en production.

5. Optimisation des performances

Les étapes vues précédemment font en fait partie d’un cycle de travail, dans lequel les allers-retours sont fréquents. Il est, en effet, extrêmement courant voire nécessaire de retourner à l’analyse et à l’exploration des données une fois que l’algorithme a donné ses premiers résultats. L’objectif étant d’affiner la sélection des variables et leurs valeurs pour améliorer les performances de nos algorithmes.

6. Déploiement

Une fois le modèle prêt, le data scientist peut présenter ses résultats d’analyse et d’explorations de données d’une part, et déployer l’algorithme en production d’autre part.

À noter que les choix de déploiement et de mise en production sont des prérequis à connaître avant de commencer un projet.