GPT-3, La singularité est proche ?

Il y a un peu plus d'un an, OpenAI dévoilait GPT-2, le modèle de traitement du langage naturel le plus puissant jamais conçu.

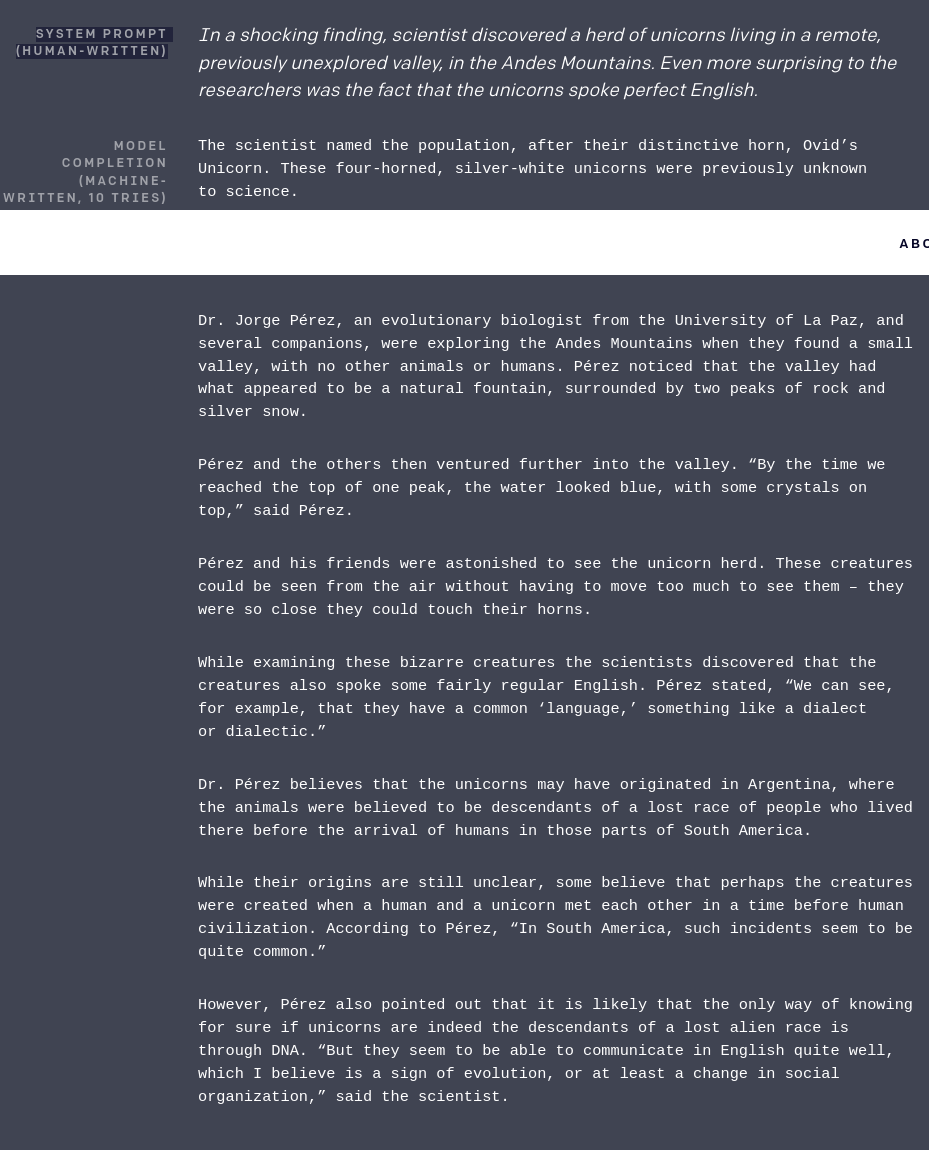

Voici le genre de prouesse dont GPT-2 est capable:

L’entraînement d'un réseau de neurones consiste en trouver les valeurs optimales pour l'ensemble de ses paramètres. Un paramètre est, pour le dire simplement, un nombre par lequel le signal qui passe d'un neurone à l'autre sera multiplié. (Pour les techniciens: oui, c'est simplifié, je ne parle ici que des poids. J'expliquerai dans un prochain article comment fonctionne réellement un neurone)

GPT-2 contenait (dans sa version la plus grande) presque deux milliards de paramètres.

Croyez moi, c'est énorme.

Il y a quelques jours était dévoilé GPT-3. Peu ou prou 200 milliards. 2 000 000 000. (En fait un peu moins mais on est plus vraiment à 10 millions près).

Et le résultat est...

Je vous laisse en juger:

Here's GPT-3 generating React components based on a _variable name_ alone, using the @OpenAI API. pic.twitter.com/YHP8gVqMLD

— Harley Turan (@hturan) July 12, 2020

This changes everything. 🤯

— Jordan Singer (@jsngr) July 18, 2020

With GPT-3, I built a Figma plugin to design for you.

I call it "Designer" pic.twitter.com/OzW1sKNLEC